chatgpt 几乎在任何主题上都拥有看似无限的知识,并且可以实时回答问题,否则需要数小时或数天的研究。公司和员工都意识到人工智能可以通过减少研究时间来加快工作速度。

缺点

然而,鉴于所有这些,一些人工智能应用程序有一个缺点。人工智能的主要缺点是结果仍然必须经过验证。

虽然通常大部分是正确的,但人工智能可以提供错误或欺骗性的数据,从而导致错误的结论或结果。

软件开发人员和软件公司已经采用了“” – 专门的聊天机器人,可以通过让ai自动编写功能或方法的大纲来帮助开发人员编写代码 – 然后可以由开发人员验证。

虽然可以节省大量时间,但副驾驶也可以编写不正确的代码。微软、亚马逊、github和英伟达都为开发人员发布了副驾驶。

聊天机器人入门

要了解 – 至少在高层次上聊天机器人的工作原理,您必须首先了解ai基础知识,特别是机器学习(ml)和大型语言模型(llm)。

机器学习是计算机科学的一个分支,致力于研究和开发尝试教计算机学习的方法。

llm本质上是一个自然语言处理(nlp)程序,它使用大量的数据和神经网络(nn)来生成文本。llm通过在大数据模型上训练ai代码来工作,然后随着时间的推移从中“学习” – 基本上根据输入数据的准确性成为特定领域的领域专家。

输入数据越多(也越准确),使用该模型的聊天机器人就越精确和正确。llm在接受数据模型训练时也依赖于深度学习。

当您向聊天机器人提问时,它会根据其与您的问题相关的所有主题的学习和存储知识,向其llm查询最合适的答案。

从本质上讲,聊天机器人已经预先计算了一个主题的知识,并且给定足够准确的llm和足够的学习时间,可以提供比大多数人更快的正确答案。

使用聊天机器人就像立即拥有一个自动化的博士团队。

2023 年 <> 月,meta ai 发布了自己的 llm,名为 llama。一个月后,谷歌推出了自己的人工智能聊天机器人bard,它基于自己的llm,lamda。此后,其他聊天机器人也随之而来。

生成式人工智能

最近,一些llm已经学会了如何生成非基于文本的数据,例如图形,音乐,甚至整本书。公司对生成式人工智能感兴趣,以创建诸如企业图形,徽标,标题甚至取代演员的数字电影场景之类的东西。

例如,本文的缩略图是由 ai 生成的。

作为生成式人工智能的副作用,工人们开始担心因人工智能软件驱动的自动化而失去工作。

聊天机器人助手

世界上第一个商业用户可用的聊天机器人()由bespoke日本于2019年为东京车站城发布。

作为ios和android应用程序发布,bebot知道如何引导您到迷宫般的车站周围的任何地方,帮助您存放和取回行李,将您送到信息台,或查找火车时间,地面交通或车站内的食物和商店。

它甚至可以告诉您前往哪个火车站台,以便按行程持续时间乘坐最快的火车前往城市中的任何目的地 – 所有这些都在几秒钟内完成。

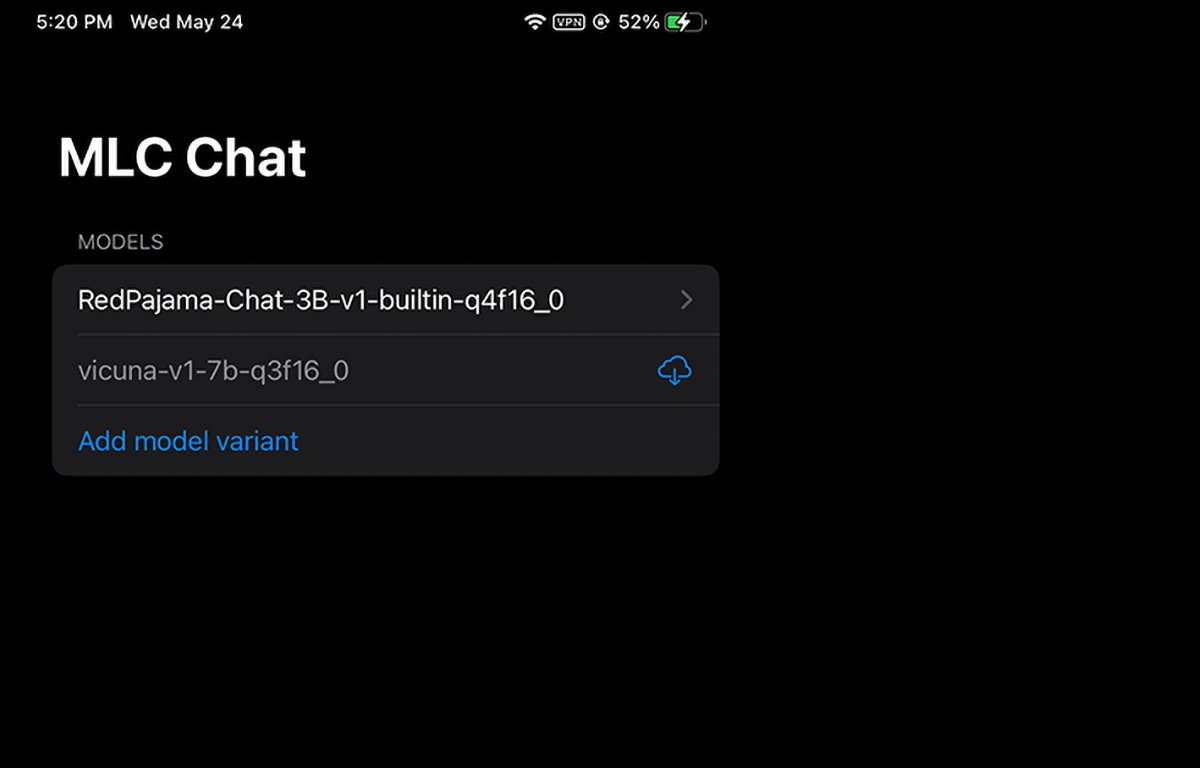

mlc 聊天应用

(mlc)项目是apache基金会深度学习研究员冯思源和金弘毅以及西雅图和中国上海的其他人的心血结晶。

mlc背后的想法是将预编译的llm和聊天机器人部署到消费者设备和web浏览器。mlc 利用消费者图形处理单元 (gpu) 的强大功能来加速 ai 结果和搜索,使 ai 触手可及,大多数现代消费者计算设备都可以使用。

另一个mlc项目web – 为web浏览器带来了相同的功能,并且又基于另一个项目 – webgpu。web llm 仅支持具有特定 gpu 的计算机,因为它依赖于支持这些 gpu 的代码框架。

大多数ai助手依赖于客户端 – 服务器模型,服务器完成大部分ai繁重的工作,但mlc将llm烘焙到直接在用户设备上运行的本地代码中,从而消除了对llm服务器的需求。

设置机器学习

若要在设备上运行 mlc,它必须满足项目和 github 页面上列出的最低要求。

要在iphone上运行它,您需要具有至少14gb可用ram的iphone 14 pro max,iphone 12 pro或iphone 6 pro。您还需要安装apple的testflight应用程序才能安装该应用程序,但安装仅限于前9,000个用户。

我们尝试在具有 2021gb 存储空间的基本 64 ipad 上运行 mlc,但它无法初始化。您的结果在 ipad pro 上可能会有所不同。

您还可以从源代码构建 mlc,并按照 mlc-llm github 页面上的说明直接在手机上运行它。您需要在 mac 上安装 git 源代码控制系统才能检索源代码。

为此,请在 mac 上的 finder 中创建一个新文件夹,使用 unix 命令在“终端”中导航到该文件夹,然后在“终端”中触发 mlc-llm github 页面上列出的命令:cdgit clone

https://github.com/mlc-ai/mlc-llm.git,然后按回车键。git 会将所有 mlc 源下载到您创建的文件夹中。

安装 mac 先决条件

对于 mac 和 linux 计算机,mlc 从终端中的命令行界面运行。需要先安装一些必备组件才能使用它:

- package manager

- 自制

- vulkan 图形库(仅限 linux 或 windows)

- git 大文件支持 (lfs)

对于 nvidia gpu 用户,mlc 说明明确指出您必须手动安装 驱动程序作为默认驱动程序。另一个用于nvidia gpu的图形库 – cuda – 将无法工作。

对于mac用户,您可以使用homebrew包管理器安装,我们之前已经介绍过。请注意,miniconda与另一个自制conda公式miniforge冲突。

因此,如果您已经通过homebrew安装了miniforge,则需要先将其卸载。

按照 mlc/llm 页面上的说明,其余的安装步骤大致如下:

- 创建新的 conda 环境

- 安装 git 和 git lfs

- 从 conda 安装命令行聊天应用

- 创建新的本地文件夹,下载 llm 模型权重并设置local_id变量

- 从 github 下载 mlc 库

所有这些都在说明页面上详细提到,因此我们不会在这里讨论设置的各个方面。最初可能看起来令人生畏,但如果您具有基本的macos终端技能,那么实际上只需几个简单的步骤。

local_id步骤只是将该变量设置为指向您下载的三个模型权重之一。

模型权重是从huggingface社区网站下载的,该网站有点像ai的github。

在终端中安装所有内容后,您可以使用mlc_chat_cli

命令。

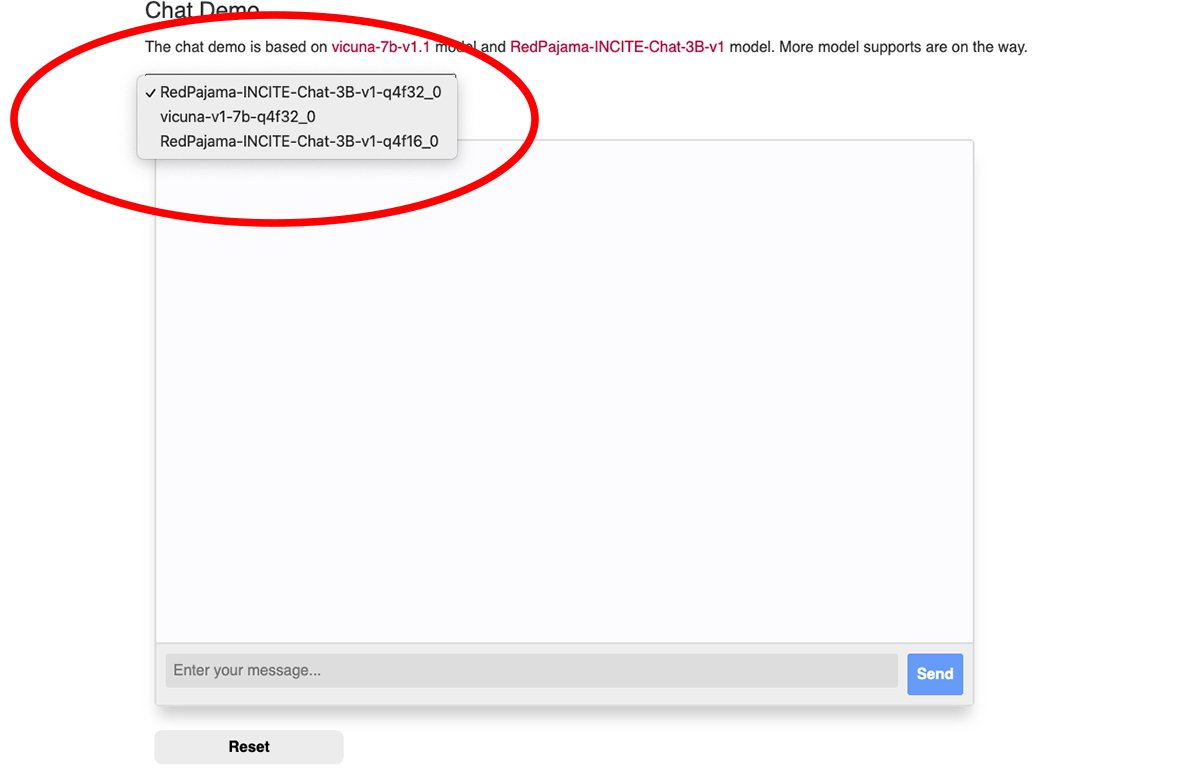

在网络浏览器中使用 mlc

mlc还有一个网络版本,。

web llm变体仅在apple silicon mac上运行。它不会在英特尔 mac 上运行,如果您尝试,它会在聊天机器人窗口中产生错误。

mlc 网络聊天窗口顶部有一个弹出菜单,您可以从中选择要使用的下载模型重量:

您需要 google chrome 浏览器才能使用 web llm(chrome 版本 113 或更高版本)。早期版本将不起作用。

您可以在mac版本中从chrome菜单中查看您的chrome版本号,方法是转到chrome->关于google chrome。如果有可用的更新,请单击“更新”按钮以更新到最新版本。

您可能需要在更新后重新启动 chrome。

请注意,mlc web llm 页面建议您使用以下命令从 mac 终端启动 chrome:

/applications/google\ chrome.app/contents/macos/google\ chrome — enable-dawn-features=allow_unsafe_apis,disable_robustness

allow_unsafe_apis’和disable_robustness’是两个chrome启动标志,允许它使用实验性功能,这些功能可能不稳定,也可能不稳定。

设置好所有内容后,只需在web llm网页聊天窗格底部的“输入您的消息”字段中键入问题,然后单击“发送”按钮。

真正的人工智能和智能助手的时代才刚刚开始。虽然人工智能存在风险,但这项技术有望通过节省大量时间和消除大量工作来改善我们的未来。

未经允许不得转载:ag凯发k8国际 » 如何在macos中使用类似chatgpt的mlc本地聊天机器人